7.1 Линейная модель

Подпункты этого параграфа:

Вводный пример

Начнем с очень простого примера. Предположим, что есть три образца некоторого

материала, массы которых ![]() ,

, ![]() и

и ![]() неизвестны.

В наличии имеются весы, допускающие случайную нормально распределенную погрешность.

Образцы взвешивают раздельно, получая при этом показания весов

неизвестны.

В наличии имеются весы, допускающие случайную нормально распределенную погрешность.

Образцы взвешивают раздельно, получая при этом показания весов ![]() ,

,

![]() и

и ![]() соответственно. Затем три образца взвешивают вместе

и получают показания весов

соответственно. Затем три образца взвешивают вместе

и получают показания весов ![]() . Если допустить, что весы всякий раз

делают независимую ошибку, то, как правило, окажется, что

. Если допустить, что весы всякий раз

делают независимую ошибку, то, как правило, окажется, что

![]() .

.

Если бы мы допустили ``идеальную'' ситуацию, когда весы определяют массу абсолютно точно, то, очевидно, в четвертом взвешивании не было бы никакого смысла. Что касается реального опыта, когда к теоретическим массам добавляются случайные ошибки, то интуитивно кажется, что четвертое взвешивание может содержать в себе полезную информацию. Вопрос только в том, как ее правильно обработать.

Общая линейная модель

Теперь сформулируем и обсудим общую модель, а затем вернемся к примеру.

Предположим, что неизвестные величины

![]() последовательно

измеряются некоторым измерительным прибором, прибавляющим случайную ошибку,

распределенную по нормальному закону

последовательно

измеряются некоторым измерительным прибором, прибавляющим случайную ошибку,

распределенную по нормальному закону

![]() . Считая эти

измерения независимыми между собой и обозначая результаты этих измерений через

. Считая эти

измерения независимыми между собой и обозначая результаты этих измерений через

![]() соответственно, запишем

соответственно, запишем

где

Так как

![]() независимы и

независимы и ![]() имеет распределение

имеет распределение

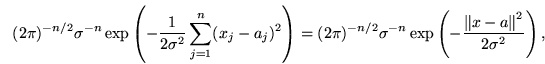

![]() , нетрудно выписать функцию правдоподобия (т.е. совместную

плотность распределения

, нетрудно выписать функцию правдоподобия (т.е. совместную

плотность распределения

![]() , см. также

, см. также

![]() 6.6):

6.6):

Как и в

-- обычное евклидово расстояние между векторами в

-- обычное евклидово расстояние между векторами в

Возвращение к примеру

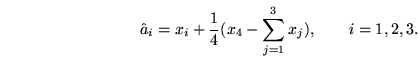

Вернемся к нашему примеру и покажем, что четвертое взвешивание вовсе не было

напрасным. Попробуем извлечь из него полезную информацию. Построим линейную

модель, соответствующую этому опыту. Обозначим через ![]() истинный суммарный

вес трех образцов. Теперь можем записать

истинный суммарный

вес трех образцов. Теперь можем записать

Согласно сказанному выше, для того чтобы найти оценку неизвестных параметров следует минимизировать по

Сравнить

![]() и

и

![]() в предыдущем примере. Вспомнить

содержание

в предыдущем примере. Вспомнить

содержание

![]() 6.5 и сделать вывод.

6.5 и сделать вывод.

Независимая выборка из нормального распределения (Примеры 6.1 и 6.3)

можно считать частным случаем линейной модели (37), если выбрать

следующее подпространство

![]() :

:

Мы не коснулись здесь вопроса о том, как оценить дисперсию

![]() погрешности прибора в модели (37) в том случае, когда она является

неизвестной. Подробное обсуждение этого вопроса можно найти в книге [12, Гл. 3, § 3]

погрешности прибора в модели (37) в том случае, когда она является

неизвестной. Подробное обсуждение этого вопроса можно найти в книге [12, Гл. 3, § 3]

|

След.: 7.2 Система нормальных уравнений ...

Пред.: 7 Метод наименьших квадратов ... Вверх: 7 Метод наименьших квадратов ... |

Оглавление

Предметный указатель |